Définition

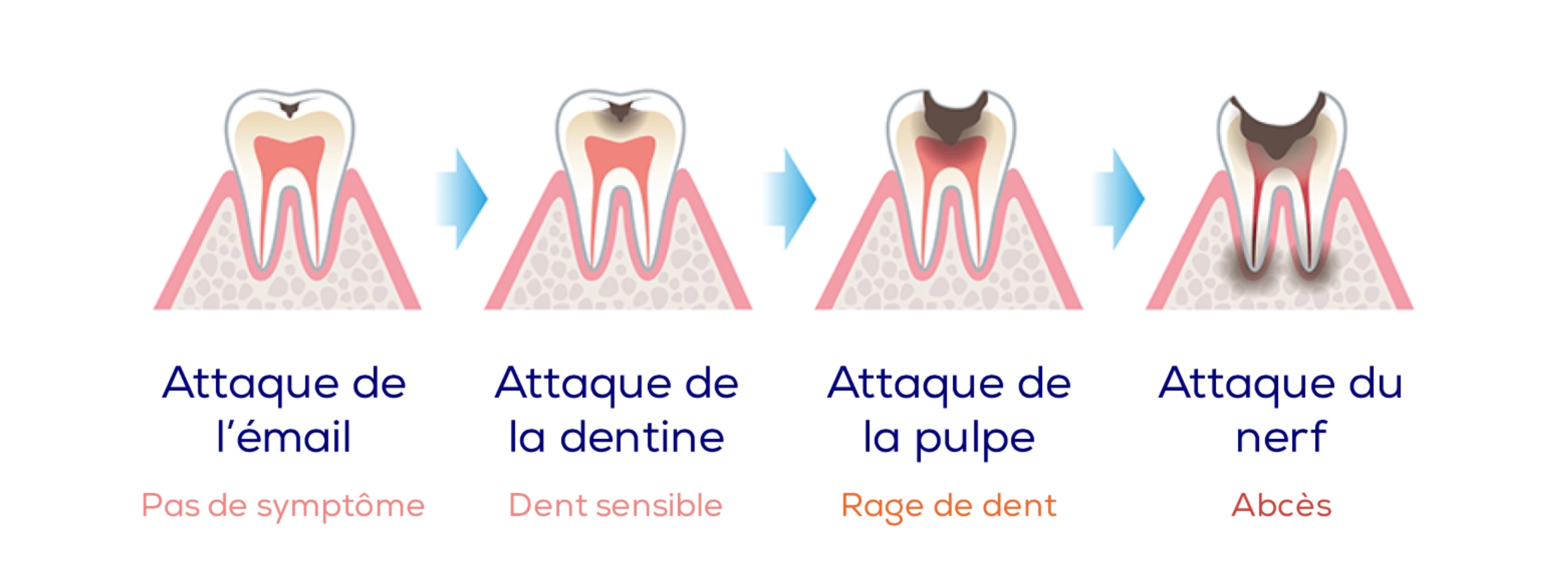

La carie est une maladie infectieuse d’origine bactérienne qui détruit progressivement la dent par déminéralisation de ses tissus durs. Elle évolue toujours de l’extérieur vers l’intérieur de la dent en formant une cavité.

Qu’est-ce qu’une carie ?

Les caries dentaires sont des cavités qui se forment dans l’émail et la dentine des dents. Elles sont causées par une accumulation de bactéries sur les dents, qui se nourrissent de sucres et produisent de l’acide. Si elles ne sont pas traitées, les caries peuvent se développer et atteindre les nerfs de la dent, entraînant une douleur intense et la nécessité d’une intervention dentaire plus importante. En fonction de chaque stade de l’évolution il existe un traitement différent.